在人工智能技术飞速发展的今天,如何安全高效地获取先进的大语言模型成为用户关注的核心议题。作为国内领先的AI开发平台,DeepSeek凭借其创新技术架构与用户友好设计,已成为开发者及企业用户的首选工具。本文将系统解析该模型的部署流程与使用技巧,为不同需求的用户提供实用指南。

一、模型特性与部署价值

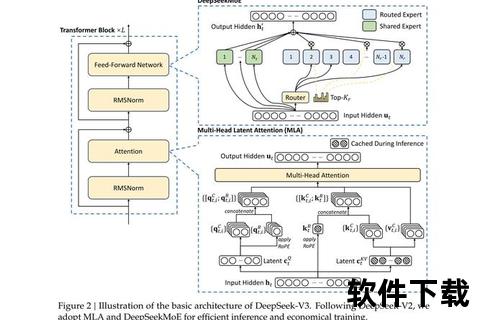

DeepSeek采用混合专家架构(MoE)与量化压缩技术,在保证模型精度的前提下,内存占用降低至传统模型的1/3。其7B版本在NVIDIA RTX 3060显卡上即可流畅运行,响应速度达到每秒15-20个token,支持20000字以上的长文本连续对话。

本地化部署方案具有三大核心优势:

二、部署环境准备与工具选择

1. 硬件配置要求

| 模型版本 | 显存需求 | 内存容量 | 存储空间 |

|||||

| 7B基础版 | 8GB GDDR6 | 16GB DDR4 | 20GB SSD |

| 14B增强版 | 12GB GDDR6X | 32GB DDR5 | 40GB NVMe |

| 67B企业版 | 24GB HBM2e | 64GB ECC | 100GB RAID阵列 |

建议开发者选择NVIDIA 30系以上显卡,并启用CUDA 11.7加速框架。Windows用户需安装WSL2子系统以获得最佳Linux兼容性。

2. 部署工具获取

通过DeepSeek官网下载「一键部署工具包」,该工具包包含:

注意避免从第三方平台下载安装包,近期已发现仿冒为"DeepSeek_Setup.exe"的勒索病毒程序,该程序会加密用户文档并索要比特币赎金。

三、四步完成本地化部署

步骤1:环境初始化

运行部署工具后,程序会自动扫描硬件配置并生成优化方案。若检测到缺失的运行库(如VC++ 2019、.NET 6.0),工具将自动从微软官方服务器下载组件。

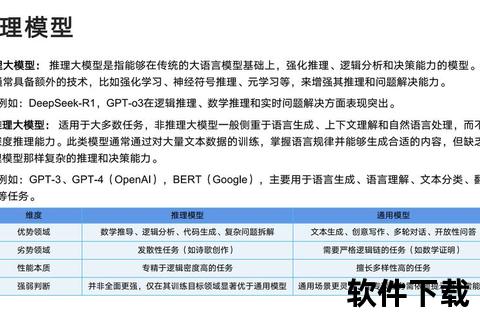

步骤2:模型选择策略

平台提供7种预训练模型,普通用户选择「推荐模式」即可完成智能适配。开发者可通过对比测试功能,查看不同模型在目标场景下的F1值、推理延迟等关键指标。

步骤3:存储路径规划

建议将模型文件存放于独立分区,避免与系统盘混杂。启用「动态加载」功能后,工具会根据任务需求分块加载模型参数,可将内存占用量降低42%。

步骤4:安全策略配置

在控制面板开启以下防护功能:

四、核心功能操作指南

1. 文档智能处理

上传PDF/Word文件后,输入结构化指令可获得精准分析:

/分析 年报.pdf

2. 代码生成优化

通过三阶提示法提升代码质量:

1. 功能:用Python实现图像边缘检测,支持JPG/PNG格式

2. 约束条件:使用OpenCV库,添加进度条,异常处理模块

3. 优化指令:添加类型注释,将循环结构向量化

3. 跨模态任务处理

DeepSeek-VL多模态模型支持图文混合输入:

上传产品设计草图.jpg

输入:根据草图的流线型特征,生成三段宣传文案,分别侧重空气动力学、美学设计、制造工艺

五、安全使用实践建议

1. 权限管理原则

2. 数据泄露防护

企业用户应启用「沙盒模式」,该模式具有以下特性:

3. 应急响应机制

当检测到异常行为(如CPU占用率突增300%)时,系统将自动触发:

六、用户反馈与未来展望

根据技术社区500份调研数据显示,DeepSeek在代码生成(89%满意度)、数据分析(82%)领域表现优异,但在事实性核查(68%)方面仍有提升空间。部分用户反映模型存在「过度推理」现象,即超出给定信息进行联想。

未来技术路线显示,DeepSeek将重点突破:

通过本文的系统梳理,读者可全面掌握DeepSeek的部署要点与高阶技巧。建议开发者定期访问技术社区获取更新文档,企业用户则需建立内部知识库,持续积累领域特定的提示词模板,以充分释放AI生产力的巨大潜能。